Давным давно, в далеком июне 2011 гугл начал учитывать в своей выдаче и ранжировании мета-теги rel=»author» и rel=»me»

Разберем все максимально коротко и понятно.

Рассмотрим проблему с точки зрения Google, он попытался решить весьма занимательную задачку:

1. Вы пишете статьи и публикуете их в разных местах.

2. Учитывая алгоритм чья первая статья проиндексирована, тот и ее автор.

3. Так кто же действительно ее автор и чей проиндексированный текст является уникальным, а чей копипастом?

4. Google решили ввести метки в статье для указания ссылки на автора, убив тем самым три зайца: авторство текста, популяризацию сервиса Google + и объединение всех статей в общую базу — ОДНА статья раскиданная по куче сайтов, вдруг имеет общую объединяющую благодаря признаку author.

5. Все просто создаете профайл Google + Если у вас еще все еще нет, то советую вам его завести.

6. На вашем сайте вы пишете ссылку на свой профайл Google +

7. Из своего сайта/блога в статьях указывайте везде автора, разумеется если это вы то вносите

<a href="https://plus.google.com/111408456304174972967" rel="me">Google +</a>

Если автор не вы, или вы размещаете статью на стороннем сайте, то вносите на нем текст наподобие

Written by <a href="https://plus.google.com/111408456304174972967" rel="author">Мы в Google+</a>

Также rel=»author» используйте для указания ссылки на автора статьи, если вы используете чьи-то ссылки.

Эта техника весьма полезна для подъема вашего бренда, как компании, так и лично вашего имени.

В итоге вы будут приобретать больший вес как в глазах гугла для его ранжирования, так и для других людей читающих ваши статьи.

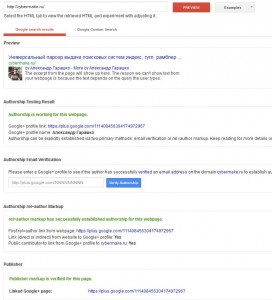

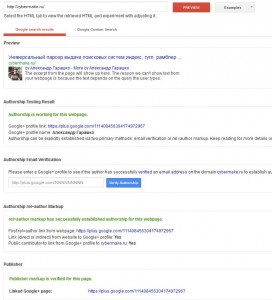

И действительно смотрите как здорово выглядит проверка авторства:

В итоге вы должны получить нечто подобное. Последний пункт Publisher у меня есть только на главной. По документации его просят внести только на основную страницу сайта.

Так что регистрируйтесь на Google +, делайте фото, привязывайте авторство статей к Google Plus и ФЛАГ ВАМ В РУКИ !!!

Ниже инструкция как добавить. На всех блогах рунета вы найдете совершенно различные описания этого процесса без нормальных комментариев.

Если и моя инструкция ломает вам голову, то в конце вы найдете ссылку для тех кто совсем ничего не понял )))

ПОШАГОВАЯ НАСТРОЙКА REL = AUTHOR, PUBLISHER & ME:

Для проверки авторства URL используйте следующий инструмент, также используйте его для тестирования верности указания ваших rel ссылок.

http://www.google.com/webmasters/tools/richsnippets

1. На главной странице вашего сайта создайте ссылку аналогичную следующей, в которой естественно замените код google + на свой.

<a href=»https://plus.google.com/111408456304174972967″ rel=»publisher»>Мы в Google+</a>

2. В футер (нижняя часть сайта) всех страниц советую вставить следующую ссылку (номер профайла подставьте свой)

<a href=»https://plus.google.com/111408456304174972967″ rel=»me»>Google +</a>

Проще эту ссылку вставить сразу в футер, чем постоянно в каждой статье указывать себя в качестве автора

3. В вашем профайле Гугл Плюс Добавьте Ссылки на ваш сайт.

4. В вашем профайле Гугл Плюс Добавьте Свои ссылки в раздел мои публикации.

Пункты 3-4 редактируются на одной закладке ССЫЛКИ в вашем профайле Google +.

Help от гугла по настройке.

Информация по добавлению publisher:

Как связать +страницу с вашим сайтом

http://support.google.com/webmasters/bin/answer.py?hl=ru&answer=1708844

Плюс два способа подтверждения автортва через email и ссылку на Google Plus

http://support.google.com/webmasters/bin/answer.py?hl=en&answer=1408986

Для тех кто совсем ничего не понял пройдите по ссылке

http://www.google.com/webmasters/tools/richsnippets

Введите ваш URL и вы получите полный Help от Google.